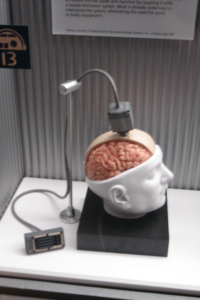

Нейрокомпьютерный интерфейс, НКИ (англ. brain–computer interface (BCI), мозго-машинный интерфейс, ММИ, интерфейс мозг-компьютер, ИМК) – это устройство, выполняющее преобразование данных об электрической или метаболической активности мозга человека (далее активности) или животного в сигналы управления внешним техническим устройством. Как правило, в однонаправленных интерфейсах внешние устройства могут либо принимать сигналы от мозга, либо посылать ему сигналы, например, имитируя сетчатку глаза при восстановлении зрения электронным имплантатом. Другие интерфейсы, так называемые двунаправленные, позволяют обмениваться информацией мозгу и внешним устройствам в обоих направлениях. Как правило нейрокомпьютерный интерфейс работает на основании принципа биологической обратной связи.

Нейрокомпьютерный интерфейс можно разделить на инвазивный и неинвазивный. Инвазивный нейрокомпьютерный интерфейс взаимодействует напрямую с клетками мозга и требует имплантировании электродов в мозг. Неинвазивный нейрокомпьютерный интерфейс регистрирует биоэлектрическую активность головного мозга с помощью внешних устройств, которые не требуют вживления.

История

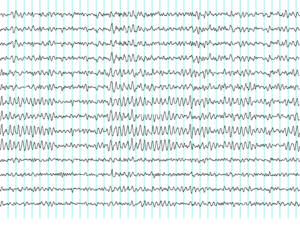

История нейрокомпьютерного интерфейса начинается с открытия Гансом Бергером электрической активности человеческого мозга и разработки электроэнцефалографии (ЭЭГ). В 1924 году Бергер первым зарегистрировал активность мозга человека с помощью ЭЭГ. Анализируя записи ЭЭГ, Бергер смог идентифицировать колебательную активность, назвав её волной Бергера или альфа-волной (8–13 Гц).

Первое записывающее устройство Бергера было очень примитивным. Он вставлял серебряные проводки непосредственно под скальп своих пациентов. Позже они были заменены серебряной фольгой, прикреплённой к голове пациента резиновыми лентами. Бергер соединил эти датчики с капиллярным электрометром Липпмана, но результаты оказались неудовлетворительными. К успеху привели более сложные измерительные устройства, такие как записывающий двухкатушечный гальванометр Сименс, который улавливал и отображал электрическое напряжение до одной десятитысячной вольта.

Бергер проанализировал взаимосвязь изменений ЭЭГ-волн с заболеваниями головного мозга. ЭЭГ открыли совершенно новые возможности для исследования деятельности человеческого мозга.

В то время, термина нейрокомпьютерный интерфейс ещё не существовало, одним из первых примеров работающего нейрокомпьютерного интерфейса была пьеса «Музыка для сольного исполнителя» (1965) американского композитора Элвина Люсье. В его пьесе используется оборудование для обработки ЭЭГ и аналоговых сигналов (фильтры, усилители и микшерный пульт) для стимуляции ударных инструментов. Для исполнения пьесы необходимо создавать альфа-волны и, таким образом, это имитирует игру на различных ударных инструментах и воспроизводится через громкоговорители, расположенные рядом с инструментами или непосредственно на них.1

Профессор Калифорнийского университета в Лос-Анджелесе Жак Видаль ввёл термин «BCI» и выпустил первые рецензируемые публикации по этой теме. Видаль широко известен как изобретатель нейрокомпьютерного интерфейса, что отражено в многочисленных рецензируемых статьях, в которых рассматривается и обсуждается данная область.234 В его статье 1973 года была сформулирована «проблема BCI»: управление внешними объектами с помощью сигналов ЭЭГ. В частности, он указал на потенциал условной отрицательной вариации (изменения) Contingent Negative Variation (CNV) как на проблему для контроля нейрокомпьютерного интерфейса. Описанный Видалем эксперимент 1977г. был первым применением нейрокомпьютерного интерфейса после его статьи 1973 года. Это был неинвазивный контроль ЭЭГ графического объекта, похожего на курсор, на экране компьютера. Это была демонстрация движения в лабиринте.

После своего открытия в 70-х годах, Видаль в течение многих лет не принимал участия ни в исследованиях, ни в мероприятиях , ни в конференциях по теме нейрокомпьютерного интерфейса. Однако в 2011 году он прочитал лекцию в Граце (Австрия), при поддержке проекта Future BNCI, представив первый нейрокомпьютерный интерфейс. Тогда его приняли с восторгом и восхищением. К Видалю присоединилась его жена Ларис Видаль, которая ранее работала с ним в Калифорнийском университете в Лос-Анджелесе над его первым проектом ИМК.

В 1988 г. был сделан отчёт о неинвазивном контроле ЭЭГ физического объекта – робота. Описанный эксперимент представлял собой ЭЭГ-контроль многократного запуска-остановки-перезапуска движения робота по произвольной траектории, начертанной линией, проведенной на полу. По умолчанию робот следит за линией, используя автономный интеллект и автономный источник энергии.56 Этот отчёт 1988 года, написанный Стево Божиновски, Михаилом Сестаковым и Лиляной Божиновской, был первым отчётом об управлении роботом с помощью ЭЭГ.78

В 1990 году был представлен отчёт о замкнутом, двунаправленном адаптивном ИМК, управляющем компьютерным зуммером с помощью упреждающего потенциала мозга, потенциала условной отрицательной вариации (CNV).9

Исследование нейрокомпьютерного интерфейса на животных

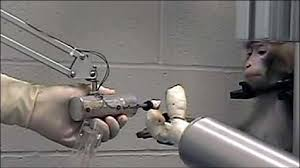

Нескольким лабораториям удалось записать сигналы от коры головного мозга обезьян и крыс, чтобы начать использовать нейрокомпьютерный интерфейс для технологии управления различными манипуляторами. Обезьяны управляли курсорами на экране компьютера и приказывали роботизированным манипуляторам выполнять простые задачи, просто думая о задаче и наблюдая визуальную обратную связь, но пока без какой-либо двигательной активности.10 В мае 2008 года в ряде известных научных журналов были опубликованы фотографии, на которых изображена обезьяна из Медицинского центра Университета Питтсбурга, управляющая роботизированной рукой с помощью мышления.11

Ранние работы

В 1969 году исследования оперантного обусловливания Фетца и его коллег в Региональном исследовательском центре приматов и на кафедре физиологии и биофизики Медицинской школы Вашингтонского университета в Сиэтле впервые показали, что обезьяны могут научиться контролировать отклонение стрелки счетчика (измерителя) биологической обратной связи с помощью нейронной активности.12 Аналогичная работа 1970-х годов установила, что обезьяны могут быстро научиться добровольно управлять скоростью возбуждения отдельных и нескольких нейронов в первичной моторной коре, если они будут чем-нибудь поощряться за создание соответствующих паттернов нейронной активности.13

Исследования, в которых были разработаны алгоритмы восстановления движений нейронов моторной коры, которые контролируют движения, относятся к 1970-м годам. В 1980-х годах Апостолос Георгопулос из Университета Джона Хопкинса обнаружил математическую связь между электрическими реакциями нейронов одиночной моторной коры у макак-резусов и направлением, в котором они двигали руками (на основе функции косинуса). Он также обнаружил, что рассредоточенные группы нейронов в разных областях мозга обезьяны совместно управляют двигательными командами, но из-за технических ограничений, связанных с его несовершенным оборудованием, он мог записывать ответные реакции нейронов только в одной области за один раз.14

Нейрокомпьютерный интерфейс начинают стремительно развиваться с середины 1990-х годов.15 Несколько групп исследователей смогли уловить сложные сигналы моторной коры головного мозга, записывая их с так называемых нейронных ансамблей (групп нейронов) и используя их для управления внешними устройствами.

Выдающиеся успехи в исследованиях

Кэннеди и Янг Дэн

Филипп Кеннеди (который открыл Neural Signals в 1987 году) и его коллеги создали первый интракортикальный интерфейс мозг-компьютер, имплантировав конические нейротрофические электроды обезьянам.

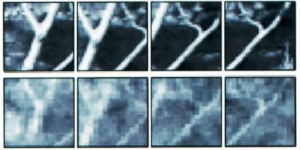

В 1999 году исследователи под руководством Янга Дэна из Калифорнийского университета в Беркли расшифровали импульсы нейронов, чтобы воспроизвести изображения, видимые кошками. Команда использовала множество электродов, встроенных в таламус (который объединяет все сенсорные участки мозга) остроглазых кошек. Исследователи нацелились на 177 клеток мозга в области латерального коленчатого ядра таламуса, которое преобразует сигналы от сетчатки. Кошкам показали восемь короткометражных фильмов и записали реакции их нейронов. Используя математические фильтры, исследователи преобразовали (декодировали) сигналы для создания видеозаписей о том, что видели кошки, и смогли воссоздать узнаваемые сцены и движущиеся объекты.16 С тех пор в Японии были проведены аналогичные исследования на людях и получены похожие результаты.

Мигель Николелис

Мигель Николелис, профессор Университета Дьюка в Дареме, Северная Каролина, был сторонником использования нескольких электродов, распределённых по большей части мозга, для получения нейронных сигналов для управления нейрокомпьютерным интерфейсом.

После проведения исследований на крысах в 1990-х годах Николелис и его коллеги разработали нейрокомпьютерные интерфейсы, которые преобразовывали мозговую активность совообразных обезьян и использовали устройства для воспроизведения движений обезьян в роботизированных руках-протезах. Обезьяны обладают развитыми способностями к хватанию, а также хорошими навыками движения рук, моторики пальцев, что делает их идеальными подопытными для такого рода работы.

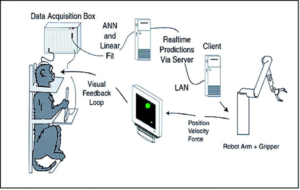

К 2000 году группе удалось построить нейрокомпьютерный интерфейс, который воспроизводил движения совообразных обезьян, когда обезьяна управляла джойстиком или тянулась за едой.17 Нейрокомпьютерный интерфейс работал в режиме реального времени, а также мог управлять отдельным манипулятором удалённо по особому Интернет-протоколу. Но обезьяны не могли видеть движение руки и не получали никакой обратной связи, это был так называемый нейрокомпьютерный интерфейс с открытым контуром.

Более поздние эксперименты Николелиса с макаками-резусами позволили замкнуть петлю обратной связи и воспроизвести движения обезьяны, тянущие и хватательные движения руки робота-манипулятора. Обезьяны-резусы с их глубоко бороздчатым мозгом со сложным рельефом считаются лучшими моделями нейрофизиологии человека, чем совообразные обезьяны. Обезьяны были обучены дотягиваться до объектов на экране компьютера и захватывать их, манипулируя джойстиком, в то время как соответствующие движения руки робота были скрыты.1819 Позже обезьянам показали робота напрямую, и они научились управлять им, наблюдая за его движениями. Нейрокомпьютерный интерфейс использовал прогноз скорости для управления движением руки и одновременно прогнозировал силу захвата. В 2011 году О’Догерти и его коллеги продемонстрировали нейрокомпьютерный интерфейс с сенсорной обратной связью на макаках-резусах. Мозг обезьяны, контролировал положение руки аватара, получая сенсорную обратную связь посредством прямой интракортикальной стимуляции в области сенсорной коры, которая отвечает за чувствительность руки.20 Другие лаборатории, разработавшие свои нейрокомпьютерные интерфейсы и алгоритмы для преобразования нейронных сигналов, включают лаборатории Джона Донохью из Университета Брауна, Эндрю Шварца из Университета Питтсбурга и Ричарда Андерсена из Калифорнийского технологического института. Эти исследователи смогли создать рабочие нейрокомпьютерные интерфейсы, даже используя записанные сигналы от гораздо меньшего числа нейронов, чем у Николелиса (15–30 нейронов против 50–200 нейронов). Группа Донохью сообщила об обучении макак-резусов использованию нейрокомпьютерного интерфейса для отслеживания визуальных целей на экране компьютера (нейрокомпьютерный интерфейс с обратной связью) с помощью джойстика или без него.21 Группа Шварца создала нейрокомпьютерный интерфейс для трёхмерного отслеживания в виртуальной реальности, а также воспроизвела управление нейрокомпьютерного интерфейса в роботизированной руке.22 Они также продемонстрировали, что обезьяна может кормить себя кусочками фруктов и зефира, используя роботизированную руку, управляемую сигналами своего собственного мозга.23 Группа Андерсена использовала записи двигательной активности задней теменной коры в своих нейрокомпьютерных интерфейсах, включая сигналы, создаваемые, когда экспериментальные животные ожидали вознаграждения.24 В дополнение к прогнозированию кинематических и кинетических параметров движений конечностей разрабатываются нейрокомпьютерные интерфейсы, которые позволяют прогнозировать и улавливать электромиографическую или электрическую активность мышц приматов.25 Такие нейрокомпьютерные интерфейсы могут быть использованы для восстановления подвижности парализованных конечностей путем электростимуляции мышц. Мигель Николелис и его коллеги продемонстрировали, что активность больших групп нейронов (нейронных ансамблей) может предсказать положение руки. Эта работа сделала возможным создание нейрокомпьютерных интерфейсов, которые считывают намерения движения руки и переводят их в движения искусственных исполнительных механизмов (протезов, манипуляторов, роботов). Кармен и его коллеги запрограммировали нейронное кодирование в нейрокомпьютерный интерфейс, которое позволяло обезьяне управлять движением руки робота (приближение и хватание). Лебедев и его коллеги утверждали, что нейронные сети мозга перестраиваются, чтобы создать новое представление о двигательных элементах робота в дополнение к представлению собственных конечностей. В 2019 году исследователи из Калифорнийского университета в Сан-Франциско опубликовали исследование, в котором продемонстрировали нейрокомпьютерный интерфейс, который потенциально может помочь пациентам с нарушением речи, вызванным неврологическими расстройствами. Их нейрокомпьютерный интерфейс использовал электрокортикографию высокой чувствительности для выявления нейронной активности мозга пациента и использовал методы глубокого обучения для синтеза речи.2627 Самым большим препятствием для технологии нейрокомпьютерного интерфейса в настоящее время является отсутствие сенсорной модели, обеспечивающей безопасный, точный и надежный доступ к сигналам мозга. Однако возможно или даже вероятно, что такой прибор будет разработан в течение следующих двадцати лет. Использование такого прибора должно значительно расширить спектр коммуникационных функций, которые могут быть реализованы с помощью нейрокомпьютерного интерфейса. Разработка и внедрение системы нейрокомпьютерного интерфейса очень сложны и требуют много времени. В ответ на эту проблему Гервин Шалк разработал универсальную систему для исследований нейрокомпьютерного интерфейса, названную BCI2000. BCI2000 находится в разработке с 2000 года в рамках проекта, возглавляемого программой исследований и разработок нейрокомпьютерного интерфейса в Центре Уодсворта Департамента здравоохранения штата Нью-Йорк в Олбани, штат Нью-Йорк, США. Использование нейрокомпьютерного интерфейса также привело к более глубокому пониманию нейронных сетей и центральной нервной системы. Исследования показали, что, несмотря на склонность нейробиологов полагать, что нейроны имеют наибольший эффект при совместной работе, отдельные нейроны тоже можно настроить с помощью нейрокомпьютерного интерфейса, что позволяет приматам управлять двигательными устройствами. Использование нейрокомпьютерного интерфейса привело к развитию принципа недостаточности одиночных нейронов, согласно которому даже при хорошо настроенной частоте срабатывания одиночные нейроны могут нести лишь ограниченный объем информации, и поэтому наивысший уровень точности достигается путем регистрации срабатываний групп нейронов (коллективного ансамбля). Другие принципы, обнаруженные с использованием нейрокомпьютерного интерфейса, включают принцип многозадачности нейронов, принцип нейрональной массы, принцип нейронного вырождения и принцип пластичности нейронов.28 Нейрокомпьютерный интерфейс также можно применять людям без инвалидности. Торстен О. Зандер и Кристиан Коте, вводят термин пассивный нейрокомпьютерный интерфейс.29 Наряду с активным и реактивным нейрокомпьютерными интерфейсами, которые используются для направленного управления, пассивные нейрокомпьютерные интерфейсы позволяют оценивать и интерпретировать изменения в состоянии испытуемого во время взаимодействия человека с компьютером (HCI). Во вторичном контуре управления компьютерная система адаптируется к своему пользователю, улучшая ее удобство использования в целом. Помимо систем нейрокомпьютерного интерфейса, которые преобразуют нейронную активность для управления внешними двигательными устройствами, системы нейрокомпьютерного интерфейса могут использоваться для кодирования сигналов с периферии. Эти сенсорные устройства позволяют в реальном времени принимать решения, имеющие отношение к поведению, на основе нейронной стимуляции с обратной связью.30 Инвазивный нейрокомпьютерный интерфейс требует хирургической операции по имплантации электродов под кожу головы для передачи сигналов мозга. Основное преимущество – более точное считывание; однако его оборотная сторона – побочные эффекты от операции. После операции могут образовываться рубцовые ткани, которые могут ослабить сигналы мозга. Кроме того, согласно исследованиям,31 организм может не принять имплантированные электроды, и это может вызвать отторжение и в дальнейшем серьезное заболевание. Инвазивные исследования нейрокомпьютерного интерфейса были нацелены на восстановление поврежденного зрения и обеспечение новых функций для людей с параличом. Инвазивный нейрокомпьютерный интерфейс имплантируются непосредственно в серое вещество мозга во время нейрохирургической операции. Поскольку нейрокомпьютерный интерфейс находятся в сером веществе, формируется сигналы самого высокого качества , однако со временем они склонны ухудшаться из-за разрастания рубцовой ткани. В дальнейшем сигналы становиться совсем слабыми или полностью исчезают.32 Прямые имплантаты мозга использовались для лечения врожденной (приобретенной) слепоты. Одним из первых ученых, создавших рабочий мозговой интерфейс для восстановления зрения, был частный исследователь Уильям Добелль. Первый прототип Добеля был имплантирован “Джерри”, человеку, ослепшему в зрелом возрасте, в 1978 году. В зрительную кору головного мозга Джерри был имплантирован однорядный нейрокомпьютерный интерфейс, содержащий 68 электродов, и с его помощью удалось произвести фосфены, то есть ощущение света. Система включала камеры, установленные на очках, для отправки сигналов на имплант. Первоначально имплант позволял Джерри видеть оттенки серого в ограниченном поле зрения с низкой частотой кадров. Это также требовало, чтобы его подключили к мэйнфрейму, но уменьшение размеров электроники и более быстрые компьютеры сделали его искусственный глаз более портативным и теперь позволяют ему выполнять простые задачи без посторонней помощи.33 В 2002 году Йенс Науманн, также ослепший в зрелом возрасте, стал первым из 16 платных пациентов, получившим имплант второго поколения “Dobelle”, что стало одним из первых коммерческих применений нейрокомпьютерного интерфейса. В устройстве второго поколения использовался более сложный имплант, позволяющий лучше отображать фосфены в когерентное зрение. Фосфены разбросаны по полю зрения, что исследователи называют «эффектом звездной ночи». Сразу после имплантации Йенс смог использовать свое не до конца восстановленное зрение, чтобы медленно проехать на автомобиле по стоянке исследовательского института. К сожалению, Добель умер в 2004 году, до того, как его исследования и разработки были задокументированы (запатентованы). Впоследствии, когда г-н Науманн и другие пациенты программы начали испытывать проблемы со зрением, облегчения не было, и они, в конце концов, снова потеряли зрение. Науманн написал о своем опыте работы с Добелем в книге «В поисках рая: отчет пациента об эксперименте с искусственным зрением»34 и вернулся на свою ферму в Юго-Восточном Онтарио, Канада, чтобы возобновить свою обычную деятельность. Нейрокомпьютерный интерфейс, специализирующиеся на двигательном нейропротезировании, нацелены либо на восстановление движения у людей с параличом, либо на предоставление устройств, помогающих им, таких как интерфейсы с компьютерами или роботизированные руки. Исследователи из Университета Эмори в Атланте во главе с Филипом Кеннеди и Роем Бакаем первыми установили человеческий мозговой имплант, который производил сигналы достаточно высокого качества для имитации движения. Их пациент, Джонни Рэй (1944–2002), страдал от «синдрома запертого человека» после перенесенного инсульта ствола головного мозга в 1997 году. Имплант Рэя был установлен в 1998 году, и он прожил достаточно долго, чтобы начать работать с имплантатом, в конечном итоге научившись управлять компьютерным курсором.35 Мэтт Нэгл, страдавший тетраплегией, стал первым человеком, который контролировал искусственную руку с помощью нейрокомпьютерного интерфейса, в 2005 году в рамках первого девятимесячного испытания на людях чипа-имплантата “Cyberkinetics BrainGate”. Имплантат BrainGate с 96 электродами, имплантированный в правую прецентральную извилину Нэгла (область моторной коры для движения руки), позволил Нэглу управлять роботизированной рукой, думая о перемещении руки, а также о компьютерном курсоре, свете и телевизоре.36 Годом позже профессор Джонатан Волпоу получил приз Фонда инноваций Альтрана за разработку мозгового компьютерного интерфейса с электродами, расположенными на поверхности черепа, а не непосредственно в мозге. Совсем недавно исследовательские группы во главе с группой BrainGate в Университете Брауна37 и группой во главе с Медицинским центром Университета Питтсбурга38 оба в сотрудничестве с Департаментом США по делам ветеранов, продемонстрировали дальнейший успех в прямом управлении роботизированными протезами конечностей, использующие прямые соединения со множеством нейронов в моторной коре головного мозга пациентов с тетраплегией. Частично инвазивные устройства нейрокомпьютерного интерфейса имплантируются внутрь черепа, но находятся вне мозга, не в толще серого вещества. Они производят сигналы с лучшим разрешением, чем неинвазивные нейрокомпьютерные интерфейсы, при которых костная ткань черепа искажает сигналы, но имеют более низкий риск образования рубцовой ткани в головном мозге, чем полностью инвазивные нейрокомпьютерные интерфейсы.39 Электрокортикография (ЭКоГ) измеряет электрическую активность мозга, регистрируемую из-под черепа, аналогично неинвазивной электроэнцефалографии, но электроды встроены в тонкую пластиковую подушечку, которая помещается над корой, под твёрдой мозговой оболочкой.40 Технологии ЭКоГ были впервые испытаны на людях в 2004 году Эриком Лойтхардтом и Дэниелом Мораном из Вашингтонского университета в Сент-Луисе. В более позднем испытании исследователи позволили мальчику-подростку играть в Space Invaders, используя свой имплант ЭКоГ.41 Это исследование показывает, что контроль осуществляется быстро, требует минимального обучения и может быть идеальным компромиссом в отношении точности сигнала и уровня инвазивности. Сигналы могут быть либо субдуральными, либо эпидуральными, но они не поступают из самой паренхимы мозга. В настоящее время единственный способ получить сигнал для исследования – это использовать пациентов, которым требуется инвазивный мониторинг для локализации и резекции эпилептогенного очага. ЭКоГ – очень многообещающий промежуточный метод нейрокомпьютерного интерфейса, поскольку он имеет более высокое пространственное разрешение, лучшее соотношение сигнал/шум, более широкий частотный диапазон и меньше требований к обучению, чем ЭЭГ, и в то же время имеет меньшую техническую сложность и меньший клинический риск. Этот профиль характеристик и недавние свидетельства высокого уровня контроля при минимальных требованиях к обучению показывают потенциал для реального применения людьми с двигательными нарушениями.4243 Также проводились эксперименты на людях с использованием неинвазивных технологий нейровизуализации. Значительное большинство опубликованных работ по нейрокомпьютерным интерфейсам включает неинвазивные интерфейсы на основе ЭЭГ. Неинвазивные технологии и интерфейсы на основе ЭЭГ используются для гораздо более широкого круга приложений. Хотя интерфейсы на основе ЭЭГ легко носить и не требуют хирургического вмешательства, они имеют относительно низкое пространственное разрешение и не могут эффективно использовать высокочастотные сигналы, поскольку череп ослабляет сигналы, рассеивая и размывая электромагнитные волны, создаваемые нейронами. Интерфейсы на основе ЭЭГ также требуют некоторого времени и усилий перед каждым сеансом использования, тогда как интерфейсы, не основанные на ЭЭГ, а также инвазивные не требуют предварительной подготовки к использованию. В целом, лучший нейрокомпьютерный интерфейс для каждого испытуемого зависит от множества факторов. В 1989 году был представлен отчет об управлении мобильным роботом движением глаз с помощью сигналов электроокулографии (ЭОГ). Мобильный робот двигался от начала до целевой точки с помощью пяти команд EOG, которые интерпретировались как вперед, назад, влево, вправо и стоп.44 ЭОГ как задача управления внешними объектами был представлен Видалем в его статье 1973 года. В статье 2016 года45 описывалось совершенно новое устройство связи и интерфейса “человек-компьютер”, не основанное на ЭЭГ, которое не требует визуальной фиксации или способности двигать глазами. Интерфейс основан на неком скрытом интересе; направление своего внимания на выбранную букву на виртуальной клавиатуре без необходимости перемещать глаза, чтобы смотреть прямо на букву. Каждая буква имеет свой собственный (фоновый) круг, яркость которого колеблется в отличие от всех остальных букв. Выбор букв основан на наилучшем совпадении между непреднамеренным колебанием размера зрачка и рисунком колебаний яркости фонового круга. Точность дополнительно повышается за счет мысленного повторения пользователем слов «яркий» и «тёмный» синхронно с переходами яркости круга вокруг букв. В 2014 и 2017 годах нейрокомпьютерный интерфейс с использованием функциональной спектроскопии в ближнем инфракрасном диапазоне для пациентов с боковым амиотрофическим склерозом (БАС) смог восстановить некоторые базовые способности пациентов общаться с другими людьми.4647 Магнитоэнцефалография (МЭГ) и функциональная магнитно-резонансная томография (ФМРТ) успешно используются в качестве неинвазивных нейрокомпьютерных интерфейсов.48 В широко известном эксперименте фМРТ позволила двум пользователям играть в пинг-понг в режиме реального времени, изменяя гемодинамическую реакцию или кровоток в головном мозге с помощью методов биологической обратной связи.49 Изменения гемодинамических реакций в реальном времени с помощью фМРТ также использовались для управления манипуляторами роботов с семисекундной задержкой между мышлением и движением.50 В 2008 году исследование, проведенное в Лабораториях вычислительной нейробиологии Advanced Telecommunications Research (ATR) в Киото, Япония, позволило учёным реконструировать изображения непосредственно из мозга и отображать их на компьютере в чёрно-белом режиме с разрешением 10×10 пикселей.51 В 2011 году исследователи52 из Калифорнийского университета в Беркли опубликовали исследование, в котором сообщалось о посекундной реконструкции видеороликов, просмотренных участниками исследования, по данным фМРТ. Это было достигнуто путем создания статистической модели, связывающей зрительные образы в видео, показываемых испытуемым, с активностью мозга, вызванной просмотром видео. Затем эта модель использовалась для поиска 100 односекундных сегментов видео в базе данных из 18 миллионов секунд случайных видеороликов YouTube, визуальные шаблоны которых наиболее точно соответствовали активности мозга, зарегистрированной, когда испытуемые смотрели новое видео. Затем эти 100 отрывков из видео продолжительностью в одну секунду были объединены в растянутое изображение, напоминающее просматриваемое видео.535455 После того, как проблема нейрокомпьютерного интерфейса была заявлена Видалем в 1973 году, первоначальные отчеты о неинвазивном подходе включали управление курсором в 2D с помощью VEP, управление зуммером с помощью CNV, контроль физического объекта, робота, с использованием ритма мозга (альфа), управления текстом, написанным на экране с помощью P300.56 На заре исследований нейрокомпьютерного интерфейса ещё одним существенным препятствием для использования электроэнцефалографии (ЭЭГ) в качестве интерфейса “мозг-компьютер” было затяжное, сложное и обширное обучение, необходимое для того, чтобы пользователи могли работать с этой технологией. Например, в экспериментах, начавшихся в середине 1990-х годов, Нильс Бирбаумер из Тюбингенского университета в Германии обучал сильно парализованных людей саморегуляции медленных корковых потенциалов в их ЭЭГ до такой степени, что эти сигналы можно было использовать в качестве сигналов для управления компьютерным курсором.57 (Бирбаумер ранее обучал эпилептиков предотвращать надвигающиеся припадки, контролируя волну низкого напряжения.) В эксперименте десять пациентов были обучены перемещать компьютерный курсор, контролируя свои мозговые импульсы. Процесс был медленным, пациенту требовалось более часа, чтобы написать курсором 100 символов, в то время как обучение часто занимало много месяцев. Однако подход с медленным кортикальным потенциалом к нейрокомпьютерным интерфейсам не использовался в течение нескольких лет, поскольку другие подходы не требуют или почти не требуют обучения, являются более быстрыми и точными и работают для большей части пользователей. Ещё один параметр исследования – это тип измеряемой колебательной активности. Герт Пфурчеллер основал лабораторию “BCI Lab” в 1991 году и предоставил результаты своих исследований по воображению движения в первом онлайновом нейрокопьютерном интерфейсе, основанном на колебательных характеристиках. Вместе с Бирбаумером и Джонатаном Вулпоу из Университета штата Нью-Йорк они сосредоточились на разработке технологии, которая позволила бы пользователям выбирать сигналы мозга, которые им легче всего использовать для управления нейрокомпьютерным интерфейсом, включая мю и бета-ритмы. Еще одним параметром является используемый метод обратной связи, и это показано в исследованиях сигналов P300. Паттерны волн P300 генерируются непроизвольно (стимул-обратная связь), когда люди видят то, что они узнают, и могут позволить нейрокомпьютерным интерфейсам преобразовывать категории мыслей без предварительной подготовки пациентов. Напротив, методы биологической обратной связи, описанные выше, требуют обучения управлению мозговыми волнами, чтобы можно было определить результирующую активность мозга. В 2005 г. было опубликовано исследование по эмуляции ЭЭГ цифровых схем управления для нейрокомпьютерного интерфейса, на примере триггера CNV.58 В 2009 г. сообщалось о неинвазивном контроле ЭЭГ роботизированной руки с помощью триггера CNV (условное отрицательное изменение).59 В 2011 году сообщалось, что управление двумя роботами-манипуляторами решало задачу Ханойской башни с тремя дисками с использованием триггера CNV. В то время как нейрокомпьютерный интерфейс на основе ЭЭГ интенсивно исследуется рядом исследовательских лабораторий, недавние достижения Бин Хе и его команды в Университете Миннесоты предполагают потенциал нейрокомпьютерного интерфейса на основе ЭЭГ для выполнения задач, близких к инвазивным интерфейсам. Используя расширенную функциональную нейровизуализацию, включая функциональную МРТ и визуализацию источника ЭЭГ, Бин Хе и его сотрудники определили совместную локализацию электрофизиологических и гемодинамических сигналов, вызванных двигательным воображением.60 Уточнив данные нейровизуализации и протокол обучения, Бин Хе и его коллеги продемонстрировали способность неинвазивного интерфейса на основе ЭЭГ управлять полётом виртуального вертолёта в трёхмерном пространстве, основываясь на двигательном воображении.61 В июне 2013 года было объявлено, что Бин Хэ разработал технику, позволяющую управлять вертолётом с дистанционным управлением через полосу препятствий.62 В дополнение к нейрокомпьютерному интерфейсу, основанному на мозговых волнах, записанных с электродов ЭЭГ на коже черепа, Бин Хе и его коллеги исследовали виртуальный интерфейс на основе сигналов ЭЭГ, используя полученную виртуальную ЭЭГ для задач нейрокомпьютерного интерфейса.63 В начале 1990-х Бабак Тахери из Калифорнийского университета в Дэвисе продемонстрировал первые одноканальные, а также многоканальные сухие активные электродные матрицы с использованием микрообработки. Конструкция одноканального сухого ЭЭГ-электрода и результаты его работы были опубликованы в 1994 г.64 Также было продемонстрировано, что матрица электродов хорошо работает по сравнению с серебрянными/хлорсеребряными электродами. Устройство состояло из четырёх участков датчиков со встроенной электроникой для снижения шума за счет согласования импеданса. Преимуществами таких электродов являются: во-первых отсутствие использования электролита, во-вторых отсутствие подготовки кожи, в-третьих значительно уменьшенный размер датчика и в-четверых совместимость с системами мониторинга ЭЭГ. Активная электродная матрица представляет собой интегрированную систему, состоящую из набора емкостных датчиков с локальной интегральной схемой, размещенной в корпусе с батареями для питания схемы. Такой уровень интеграции был необходим для достижения функциональных характеристик электрода. Электрод был протестирован на электрическом испытательном стенде и на людях в четырёх типах ЭЭГ-активности, а именно: Характеристики сухого электрода по сравнению со стандартными влажными электродами были намного лучше с точки зрения подготовки кожи, отсутствия потребности в геле (сухой) и более высокого отношения сигнал/шум.65 В 1999 году исследователи из Университета Кейс Вестерн Резерв в Кливленде, штат Огайо, под руководством Хантера Пекхэма, использовали установку ЭЭГ с 64 электродами, чтобы вернуть ограниченные движения рук парализованному Джиму Джатичу. Поскольку Джатич сконцентрировался на простых, но противоположных понятиях, таких как «вверх» и «вниз», его выходные данные ЭЭГ с бета-ритмом были проанализированы с помощью программного обеспечения для выявления паттернов в шуме. Был идентифицирован базовый образец, который использовался для управления переключателем: активность выше среднего была включена, ниже средней – выключена. Помимо того, что Джатич мог управлять компьютерным курсором, сигналы также использовались для управления нервными контроллерами, встроенными в его руки, восстанавливая некоторое движение.66 В 2009 году ученые Государственного университета в Синьчжу, Тайвань, сообщили о нейрокомпьютерном интерфейсе, который представлял собой головную повязку (Brain-Computer-Interface-Headband). Исследователи, которые разработали это головное устройство, также разработали сухие электроды на основе кремния MicroElectro-Mechanical System (MEMS), предназначенные для нанесения на участки тела без волос. Эти электроды крепились к плате DAQ в головное устройство с помощью защелкивающихся держателей электродов. Модуль обработки сигналов измерял альфа-активность, а телефон с поддержкой Bluetooth оценивал бдительность и способность пациентов к когнитивным функциям. Когда субъект становился сонным, телефон отправлял оператору возбуждающую обратную связь, чтобы разбудить его.67 В 2011 году исследователи сообщили о нейрокомпьютерном интерфейсе интегрированном в сотовой телефон и способном принимать данные ЭЭГ и преобразовывать их в команду, заставляющую телефон звонить. Это исследование было частично поддержано Abraxis Bioscience LLP, Исследовательской лабораторией армии США и Управлением армейских исследований. Разработанная технология представляла собой носимую систему, состоящую из четырёхканального модуля сбора/усиления биосигнала, модуля беспроводной передачи и сотового телефона с поддержкой Bluetooth. Электроды были размещены так, чтобы они улавливали устойчивые визуальные вызванные потенциалы (SSVEP).68 SSVEP – это биоэлектрические реакции на мерцающие зрительные стимулы с частотой повторения более 6 Гц, которые лучше всего обнаруживаются в теменной и затылочной областях зрительной коры мозга.69 Сообщается, что с этой настройкой нейрокомпьютерного интерфейса все участники исследования могли инициировать телефонный звонок в естественной среде. Учёные утверждают, что их исследования с использованием одноканального быстрого преобразования Фурье Fast Fourier transform (FFT) и алгоритма канонического корреляционного анализа canonical-correlation analysis (CCA – это способ получения информации из матриц взаимной корреляции) многоканальной системы поддерживают возможности мобильных нейрокомпьютерных интерфейсов.70 Алгоритм CCA применялся и в других экспериментах по исследованию нейрокомпьютерных интерфейсов с заявленной высокой производительностью как по точности сигнала, так и по скорости передачи сигнала.71 Хотя технология нейроинтерфейса на основе сотовой связи была разработана для инициирования телефонного звонка от SSVEP, исследователи заявили, что она может быть применена и в других областях, таких как получение сенсомоторных мю/бета-ритмов, чтобы функционировать как нейрокомпьютерный интерфейс на основе двигательных образов. В 2013 году были проведены сравнительные испытания нейрокомпьютерного интерфейса на базе сотовых телефонов, планшетов и компьютеров на базе Android, в ходе которых была проанализирована спектральная плотность мощности полученных ЭЭГ. Заявленные цели этого исследования, в котором участвовали учёные, частично поддерживаемые Исследовательской лабораторией армии США, заключались в том, чтобы повысить практичность, мобильность и повсеместность нейрокомпьютерного интерфейса на основе SSVEP для повседневного использования. Сообщалось, что частота стимуляции на всех средах была точной, хотя сигнал сотового телефона демонстрировал некоторую нестабильность. Также сообщалось, что амплитуды SSVEP для ноутбука и планшета были больше, чем для мобильного телефона. Эти две качественные характеристики были предложены в качестве индикаторов возможности использования мобильного нейрокомпьютерного интерфейса. В 2011 году исследователи заявили, что дальнейшая работа должна быть направлена на простоту использования, надежность производительности и снижение затрат на оборудование и программное обеспечение. Одна из трудностей с расшифровкой ЭЭГ – большая подверженность артефактам движения.72 В большинстве ранее описанных исследовательских проектов участников просили сидеть неподвижно, максимально уменьшив движения головы и глаз. Однако, поскольку основное применение этих технологий заключалось в создании мобильного устройства для повседневного использования, эту технологию всё же пришлось испытать в движении. В 2013 году исследователи протестировали мобильную версию нейрокомпьютерного интерфейса на основе ЭЭГ, измеряя SSVEP участников, когда они ходили по беговой дорожке с разной скоростью. Это исследование было поддержано Управлением военно-морских исследований, Управлением армейских исследований и Исследовательской лабораторией армии США. Полученные результаты заключались в том, что с увеличением скорости обнаруживаемость SSVEP с использованием CCA снижалась. Поскольку анализ независимых компонент independent component analysis (ICA – это вычислительный метод в обработке сигналов для разделения многомерного сигнала на аддитивные подкомпоненты) показал свою эффективность в отделении сигналов ЭЭГ от шума73, ученые применили ICA к ССА, извлеченным из данных ЭЭГ. Они заявили, что данные CCA с обработкой ICA и без неё были одинаковыми. Таким образом, они пришли к выводу, что CCA независимо продемонстрировала устойчивость к артефактам движения, что указывает на то, что этот алгоритм может быть полезным для применения к нейрокомпьютнерным интерфейсам, используемым в реальных условиях. В 2020 году исследователи из Калифорнийского университета использовали вычислительную систему, связанную с интерфейсами, для преобразования мозговых волн в предложения. Однако их расшифровка ограничивалась 30–50 предложениями, даже несмотря на то, что процент ошибок в словах составлял всего 3%.74 Неинвазивные нейрокомпьютерные интерфейсы также применялись для управления при помощи мозга протезами верхних и нижних конечностей у людей с параличом. Например, Герт Пфурчеллер из Технологического университета Граца и его коллеги продемонстрировали управляемую нейрокомпьютерным интерфейсом систему функциональной электрической стимуляции для восстановления движений верхних конечностей у человека с тетраплегией из-за травмы спинного мозга.75 В период с 2012 по 2013 год исследователи из Калифорнийского университета в Ирвине впервые продемонстрировали, что можно использовать технологию нейрокомпьютерного интерфейса для восстановления управляемой мозгом ходьбы после травмы спинного мозга. В своем исследовании травм спинного мозга они показали, что человек с параплегией смог использовать роботизированный протез для ходьбы с помощью нейроинтерфейса, чтобы восстановить базовое передвижение, управляемое мозгом.76 В 2009 году Алекс Блейни, независимый исследователь из Великобритании, успешно использовал Emotiv EPOC для управления 5-осевым манипулятором. Затем он создал несколько демонстрационных инвалидных колясок с управляемым сознанием и с системой автоматизации, которыми могли управлять люди с ограниченным двигательным контролем или без него, например, с параличом нижних конечностей и церебральным параличом. В 2001 году группой независимых нейробиологов и инженеров был инициирован проект OpenEEG.77 “ModularEEG” был основным устройством, созданным сообществом проекта OpenEEG; это была 6-канальная плата, для захвата сигнала, стоимость изготовления которой составляла от 200 до 400 долларов. Проект OpenEEG ознаменовал собой важный момент в появлении интерфейса между мозгом и компьютером, который можно было сделать своими руками вне лаборатории. В 2013 году OpenBCI создали высококачественную 8-канальную плату для сбора данных ЭЭГ, известную как 32-битная плата, которая продавалась по цене менее 500 долларов. Два года спустя они создали первую напечатанную на 3D-принтере ЭЭГ-гарнитуру, известную как Ultracortex, а также 4-канальную плату сбора данных ЭЭГ, известную как Ganglion Board, которая продавалась по цене менее 100 долларов. Двигательные образы включают воображение движения различных частей тела, что приводит к активации сенсомоторной коры, которая модулирует сенсомоторные колебания в ЭЭГ. Это может быть обнаружено нейрокомпьютерным интерфейсом, чтобы сделать вывод о намерениях пользователя. Двигательные образы обычно требуют нескольких тренировок, прежде чем будет достигнут приемлемый контроль над интерфейсом. Эти учебные занятия могут занять несколько часов в течение нескольких дней, прежде чем пользователи смогут последовательно применять эту технику с приемлемым уровнем точности. Независимо от продолжительности тренировки, пользователи иногда не могут освоить схему управления. Это приводит к очень медленному игровому процессу.78 Недавно были разработаны передовые методы компьютерного обучения для вычисления предметно-ориентированной модели для определения характеристик двигательных образов. Биологическая обратная связь используется для наблюдения за психическим расслаблением субъекта. В некоторых случаях биологическая обратная связь контролирует не электроэнцефалографию (ЭЭГ), а параметры организма, такие как электромиография (ЭМГ), гальваническое сопротивление кожи galvanic skin response (GSR – кожно-гальваническая реакция (КГР) — биоэлектрическая реакция, которая регистрируется с поверхности кожи) и вариабельность сердечного ритма Heart rate variability (HRV – физиологическое явление, проявляющееся в изменении интервала между началами двух соседних сердечных циклов). Многие системы биологической обратной связи используются для лечения определенных заболеваний, таких как синдром дефицита внимания и гиперактивности (СДВГ), проблемы со сном у детей, скрежетание зубами и хроническая боль. Системы биологической обратной связи ЭЭГ обычно контролируют четыре разных диапазона (тета: 4–7 Гц, альфа: 8–12 Гц, SMR: 12–15 Гц, бета: 15–18 Гц) и предлагают субъекту контролировать их. Пассивный нейрокомпьютерный интерфейс обогащает взаимодействия человек-машина информацией о фактическом состоянии пользователя, например, симуляциями для определения того, когда пользователи намереваются нажать на тормоз во время экстренной остановки автомобиля. Разработчики игр, использующие пассивные нейрокомпьютерные интерфейсы, должны осознавать, что при повторении уровней игры когнитивное состояние пользователя будет изменяться или адаптироваться. Во время первого прохождения уровня пользователь будет реагировать на вещи иначе, чем во время второго прохождения: например, пользователь будет меньше удивлен событию в игре. VEP – это электрический потенциал, регистрируемый после того, как субъекту предъявляют определенный тип визуальных стимулов. Есть несколько типов VEP. Стабильные визуально вызванные потенциалы (SSVEP) используют потенциалы, генерируемые возбуждением сетчатки, с использованием визуальных стимулов, модулируемых на определенных частотах. Стимулы SSVEP часто формируются из чередующихся шаблонов шахматной доски и иногда просто используют мигающие изображения. Частоту смены фазы используемого стимула можно четко различить в спектре ЭЭГ; это делает обнаружение стимулов SSVEP относительно простым. SSVEP доказал свою эффективность во многих нейрокомпьютерных интерфейсах. Это происходит из-за нескольких факторов: вызванный сигнал можно измерить в такой большой популяции, как кратковременный VEP, а мигание и электрокардиографические артефакты не влияют на отслеживаемые частоты. Кроме того, сигнал SSVEP исключительно устойчив. Топографическая организация первичной зрительной коры такова, что более широкая область получает афференты от центральной или фовиальной (область центральной ямки) области поля зрения. Однако у SSVEP есть несколько недостатков. Главный из которых заключается в том, что при длительном просмотре на мигающие символы, они могут вызывать раздражение и неудобства во время длительных игровых сессий, которые могут длиться час и более. Другой тип VEP, используемый с приложениями – это потенциал P300. Связанный с событием потенциал P300 – это положительный пик на ЭЭГ, который происходит примерно через 300 мс после появления целевого стимула (стимула, которого пользователь ждёт или ищет) или необычных стимулов. Амплитуда P300 уменьшается по мере того, как целевые стимулы и игнорируемые стимулы становятся более похожими. Считается, что P300 связан с процессом внимания более высокого уровня или ориентировочной реакцией, использующей P300 в качестве схемы управления. Первым приложением, использующим модель P300, была матрица P300. В рамках этой системы испытуемый выбирает букву из сетки 6 на 6 букв и цифр. Строки и столбцы сетки мигали последовательно, и каждый раз, когда загоралась выбранная «буква выбора», активировался пользовательский P300. Однако процесс коммуникации, со скоростью примерно 17 символов в минуту, был довольно медленным. P300 – это нейрокомпьютерный интерфейс, который предлагает дискретный выбор, а не непрерывный механизм управления. Преимущество использования P300 в играх заключается в том, что игроку не нужно учить себя использовать совершенно новую систему управления, и поэтому ему нужно только проводить короткие обучающие сеансы, чтобы изучить механику игрового процесса. Гервин Шалк, получивший грант в размере 2,2 миллиона долларов, обнаружил, что использование сигналов ЭКоГ может различать гласные и согласные буквы, встроенные в произносимые и воображаемые слова, проливая свет на отдельные механизмы, связанные с производством гласных и согласных букв, и может стать основой для мозгового общения с использованием воображаемой речи.79 В 2002 году Кевин Уорвик ввёл в свою нервную систему набор из 100 электродов, чтобы связать свою нервную систему с Интернетом для исследования возможностей улучшения коммуникации. После этого Уорвик успешно провел серию экспериментов. С помощью электродов, имплантированных в нервную систему его жены, они провели первый эксперимент по прямой электронной связи между нервными системами двух людей.80818283 Другая группа исследователей смогла достичь сознательной связи между мозгами двух людей, разделенных расстоянием, с помощью неинвазивной технологии, устройством, которое контактировало с кожей головы участников. Слова кодировались двоичными потоками с использованием последовательностей нулей и единиц с помощью воображаемого человека, «излучающего» информацию. В результате этого эксперимента случайные биты информации содержали закодированные слова «hola» («привет» по-испански) и «ciao» («привет» или «до свидания» по-итальянски) и передавались мысленно между люди, разделенными расстоянием, с заблокированными двигательными и сенсорными системами. Исследования синтетической телепатии с использованием субвокализации ведутся в Калифорнийском университете в Ирвине под руководством ведущего ученого Майка Д’Змура. Первое такое общение произошло в 1960-х годах с использованием ЭЭГ для создания кода Морзе с использованием альфа-волн мозга. Использование ЭЭГ для передачи воображаемой речи менее точно, чем инвазивный метод установки электрода между черепом и мозгом.84 27 февраля 2013 года группа с Мигелем Николелисом из Университета Дьюка и IINN-ELS успешно соединили мозги двух крыс с электронными интерфейсами, которые позволили им напрямую обмениваться информацией, в первом в истории прямом нейрокомпьютерном интерфейсе.858687Донохью, Шварц и Андерсен

Другие исследования

Исследование нейрокомпьютерного интерфейса на человеке

Инвазивные нейрокомпьютерные интерфейсы

Исследование зрения

Исследование движения

Частично инвазивные нейрокомпьютерные интерфейсы

Неинвазивные нейрокомпьютерные интерфейсы

Нейрокомпьютерные интерфейсы, не основанный на ЭЭГ:

Электроокулография

Исследования построенные на изучении динамики колебаний диаметра зрачка

Функциональная ближняя инфракрасная спектроскопия

МЭГ и фМРТ

Нейрокомпьютерные интерфейсы на основе электроэнцефалографии (ЭЭГ):

Массивы сухих активных электродов

Мобильные нейрокомпьютерные интерфейсы

Ограничения использования нейрокомпьютерного интерфейса

Применение нейрокомпьютерных интерфейсов в протезировании

Нейрокомпьютерный интерфейс для самостоятельной работы. Интерфейс с открытым исходным кодом

Стратегии исследования нейрокомпьютерного интерфейса в нейрогейминге

Двигательные образы

Биологическая обратная связь в нейрокомпьютерном интерфейсе

Визуальный вызванный потенциал Visual evoked potential (VEP)

Синтетическая телепатия/безмолвное общение

Footnotes

Organised Sound, 19(1), 17–29. doi: 10.1017/S135577181300037X.